En el mundo de la inteligencia artificial, las siglas RAG han ganado protagonismo en los últimos años. Detrás de ellas se esconde uno de los avances más importantes en la forma en que los modelos de lenguaje (como ChatGPT o Gemini) acceden, interpretan y generan información.

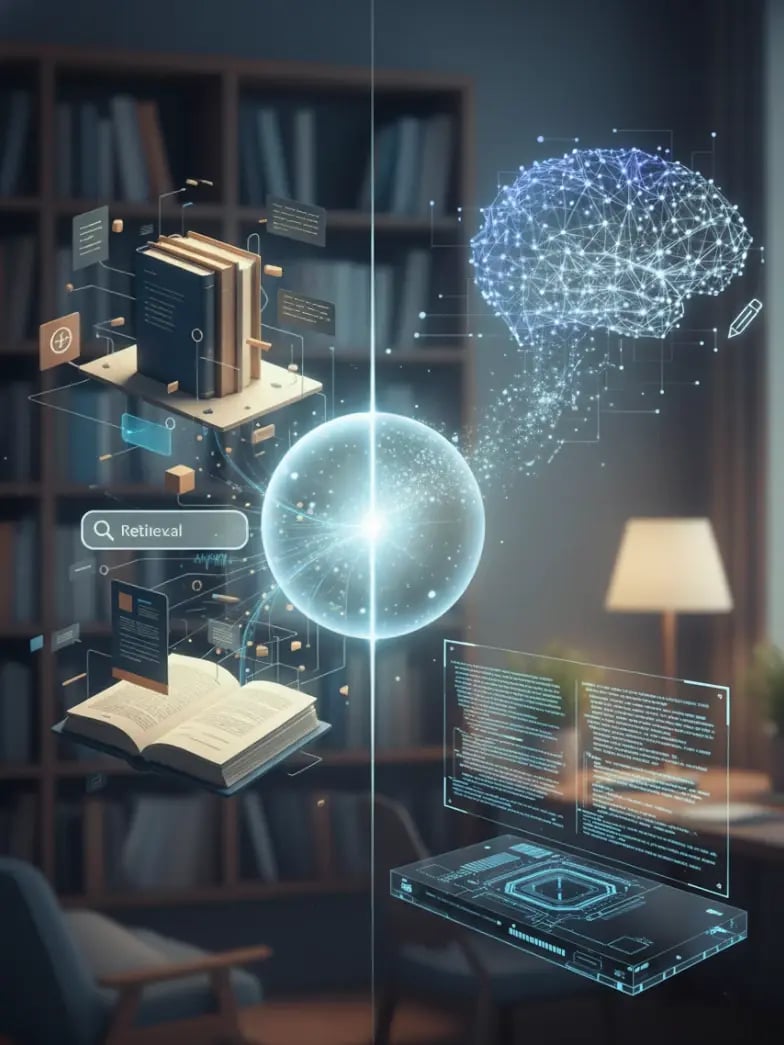

RAG, abreviatura de Retrieval-Augmented Generation, combina lo mejor de dos mundos: la capacidad de buscar información actualizada en tiempo real y la de generar texto natural, coherente y contextualizado.

En otras palabras, RAG convierte a la IA en algo más que un modelo entrenado: la transforma en una herramienta viva que aprende constantemente de fuentes externas.

Para entender por qué este enfoque es tan revolucionario, conviene primero comprender qué lo diferencia de los modelos tradicionales y en qué escenarios aporta más valor.

Qué es RAG (Retrieval-Augmented Generation)

Cuando hablamos de RAG, nos referimos a una arquitectura que amplía las capacidades de los modelos de lenguaje grandes (LLMs) al permitirles acceder a información fuera de su base de entrenamiento.

Los modelos tradicionales, incluso los más potentes, funcionan como una gran biblioteca cerrada: saben lo que aprendieron durante su entrenamiento, pero no pueden consultar fuentes nuevas una vez ese proceso termina.

Esto los hace propensos a cometer errores, sobre todo en contextos donde la información cambia constantemente o se requiere un conocimiento muy específico. En cambio, la RAG es una técnica que combina dos procesos complementarios:

- El primero es el retrieval, o recuperación de información. En esta fase, el sistema busca datos relevantes en fuentes externas como bases de conocimiento, documentos internos, APIs o incluso la web.

- El segundo es la generation, o generación de texto, donde el modelo usa la información recuperada para construir una respuesta completa, precisa y adaptada al contexto del usuario.

El resultado es un sistema capaz de responder con información actual y contrastada, superando una de las mayores limitaciones de la IA generativa: la dependencia del entrenamiento previo.

Cómo funciona RAG en la práctica

El funcionamiento de RAG se basa en una interacción dinámica entre el modelo y una base de conocimiento externa.

Todo comienza cuando el usuario introduce una pregunta o solicitud. En lugar de intentar responder únicamente con la información que tiene almacenada, el modelo busca documentos o fragmentos de texto relevantes en una o varias fuentes. Esa información se filtra, se clasifica y se incorpora al contexto de la conversación, permitiendo que la respuesta final se genere con base en datos reales y actualizados.

Por ejemplo, si un usuario pregunta “¿cuáles son los nuevos requisitos del Reglamento de Inteligencia Artificial de la Unión Europea?”, un modelo tradicional podría ofrecer información desactualizada o imprecisa. En cambio, un sistema basado en RAG consultará los textos más recientes del reglamento o fuentes oficiales, procesará su contenido y elaborará una respuesta actualizada y explicada con lenguaje natural.

De esta forma, el modelo no solo “recuerda”, también “consulta y razona”, generando un contenido más confiable.

Ejemplo de aplicación de RAG

Pensemos en una empresa que quiere crear un asistente virtual de atención al cliente.

Un chatbot tradicional respondería basándose únicamente en la información con la que fue entrenado, lo que implica que cualquier cambio en precios, políticas o productos requeriría volver a entrenarlo.

Sin embargo, si ese mismo asistente utiliza RAG, podría conectarse directamente a las bases de datos de la empresa, a los manuales técnicos o al CRM, obteniendo siempre respuestas actualizadas.

Así, cuando un cliente pregunta por un nuevo modelo de producto o una política de devolución reciente, el asistente con RAG accede a los datos más recientes y genera una respuesta precisa, sin necesidad de haber sido reentrenado.

Por todo ello, el sistema se vuelve más fiable, adaptable y escalable, y capaz de mantener la coherencia entre el conocimiento corporativo y la experiencia del usuario.

Cuándo conviene usar RAG

RAG no es una solución universal, pero sí resulta especialmente valiosa cuando la aplicación de inteligencia artificial debe manejar información dinámica, sensible o en constante evolución.

Un caso evidente es el de las organizaciones que gestionan grandes volúmenes de documentación interna, como informes técnicos, políticas de cumplimiento o manuales de procesos. En estos entornos, el conocimiento cambia con frecuencia y no tiene sentido reentrenar el modelo cada vez que se actualiza un archivo.

También es muy útil en sectores donde la precisión y la trazabilidad son esenciales, como el financiero, el sanitario o el legal. Un sistema con RAG puede consultar directamente las normativas más recientes, los informes médicos más actualizados o las bases de datos de jurisprudencia antes de emitir una respuesta, reduciendo drásticamente el riesgo de error.

En el ámbito corporativo, muchas empresas están utilizando RAG para construir asistentes internos de conocimiento, capaces de responder dudas de empleados sobre procesos, políticas o herramientas específicas.

Con esto queremos decir que deberías usar RAG cuando necesites que tu modelo acceda a información que cambia rápidamente, que esté fuera de su entrenamiento inicial o que provenga de fuentes privadas que no pueden incluirse en datasets públicos.

Cuándo no es necesario aplicar RAG

Aunque RAG es una herramienta poderosa, no siempre es la mejor opción.

Si el dominio de conocimiento es estable y no cambia con frecuencia, o si el proyecto requiere respuestas más creativas que precisas (por ejemplo, redactar contenido, generar guiones o escribir historias), puede ser más eficiente recurrir a modelos ajustados mediante fine-tuning.

Estos modelos, aunque menos dinámicos, ofrecen una velocidad de respuesta mayor y un coste computacional más bajo, al no depender de un proceso de recuperación de información externa en cada consulta.

También hay que tener en cuenta que la implementación de RAG exige una infraestructura más compleja, ya que requiere integrar bases de datos vectoriales, sistemas de indexación y herramientas de búsqueda semántica. Si tu proyecto no necesita acceso constante a datos externos, el esfuerzo de implementación podría no justificarse.

Encuentra a los mejores expertos en RAG freelance con Shakers

Implementar una solución de RAG no solo requiere conocimiento teórico, sino experiencia práctica en integración de modelos, bases de datos vectoriales, embeddings y pipelines de recuperación.

El problema es que los perfiles capaces de hacerlo son escasos, muy demandados y, en muchos casos, difíciles de asumir en plantilla por su alto coste.

A modo orientativo, un ingeniero de IA con experiencia en RAG puede superar fácilmente los 70.000 o 80.000 euros anuales, sin contar los gastos asociados a contratación, formación y mantenimiento de la infraestructura. Por eso, muchas empresas están optando por una alternativa más ágil y rentable: colaborar con expertos RAG freelance a través de Shakers.

En Shakers trabajamos con una comunidad de más de 10.000 profesionales tecnológicos verificados, entre ellos ingenieros de datos, desarrolladores de IA, machine learning engineers y arquitectos especializados en RAG y LLMs.

No cualquier freelance puede formar parte de Shakers, pues cada uno ha sido evaluado en profundidad, revisando su experiencia, certificaciones y proyectos anteriores para garantizar que solo colaboras con talento de primer nivel.

Este modelo flexible te permite acceder a talento especializado sin asumir costes fijos, reducir los tiempos de implementación y mantener el control total de tu presupuesto.

Ya no necesitas contratar un equipo entero de IA para desarrollar tu estrategia con RAG: puedes incorporar el perfil exacto que necesitas, cuando lo necesitas y escalar según la evolución de tu proyecto.

En un contexto donde la innovación avanza más rápido que los presupuestos, apostar por talento freelance validado es la forma más inteligente de integrar IA avanzada en tu empresa sin poner en peligro la rentabilidad.

Cómo funciona Shakers

El proceso es simple y ágil:

- Regístrate en nuestra plataforma y cuéntanos tu proyecto: qué objetivos tecnológicos tienes, qué desafíos enfrentas y qué tipo de colaboración buscas.

- Nuestra IA de matching analizará tu solicitud y te mostrará a los freelancers que mejor se ajustan a tus necesidades y a la cultura de tu empresa.

- Una vez elijas al candidato perfecto, podrás agendar una reunión, formalizar la colaboración y empezar a trabajar juntos en la hoja de ruta tecnológica que impulsará tu negocio.

Olvídate de interminables entrevistas de trabajo a decenas de candidatos: con Shakers encontrarás al mayor experto en RAG y LLM Fine Tuning en tiempo récord.